本稿では、AWS re:Invent 2025 の EXPO 内 Builder’s Fair で展示された内容の紹介になります。

具合悪くなったらまずビタミンをとれ!リンゴ食え!

内村でございます。

ただいま、アメリカはネバダ州のラスベガスで開催されている AWS re:Invent 2025 に参加しています。(2本目)

今年の re:Invent でも、開発者による手作りデモが集まる『Builder’s Fair』は大盛況でした。

本記事では、私が気になってたブース「Command a Robot with Amazon Bedrock」をレポートします。

内容についての諸注意

当記事は 2025年12月時点で調査した製品、サービス内容を記載しています。 最新の情報に関しては各種公式サイト、マニュアル等をご確認下さい。

当記事作成の際には十分注意しておりますが、内容に公式と相違がある場合は公式を優先とさせていただきます。

当記事内の試算およびそれに準ずる内容は、本資料の説明のために用いるものであり、不利益が生じた場合、一切の責任は負いかねますので予めご了承ください。

- 内容についての諸注意

- Command a Robot with Amazon Bedrock ブースとは

- ユースケース セキュリティ監視ロボットを自然言語で操作

- Bedrock+サーバレス+IoT Core のシンプル構成

- 興味を持ったポイント

- エンタープライズへの応用アイデア

- まとめ

Command a Robot with Amazon Bedrock ブースとは

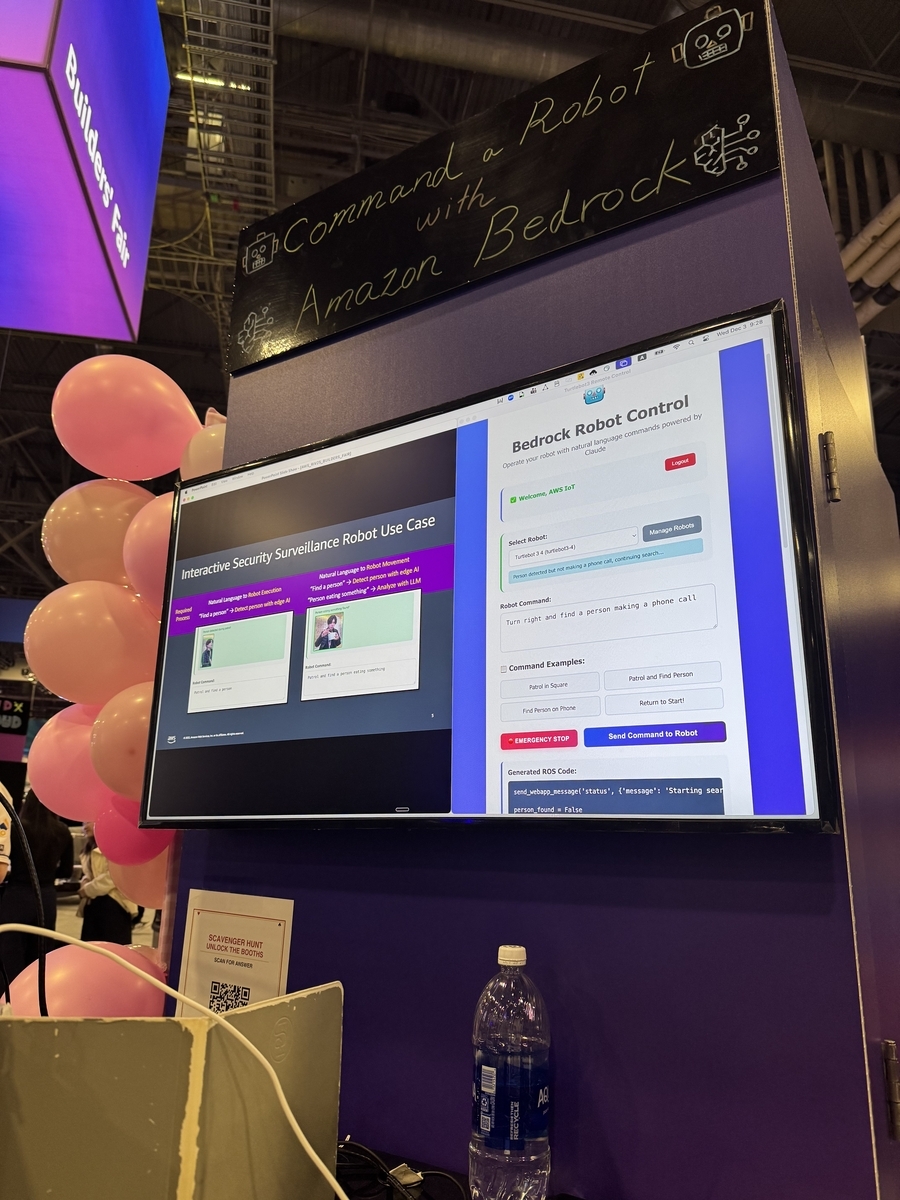

AWS やパートナーが出展している EXPO には様々なブースがあります。 このブースの黒板には『Command a Robot with Amazon Bedrock』の文字。 ピンクのバルーンに囲まれた可愛らしい見た目とは裏腹に、内容はなかなか本格派です。

モニター内には「Bedrock Robot Control」という Web アプリが表示されています。 以下のコマンドが確認できます。

- Patrol in a square

- Find Person on Phone

- Patrol and Find Person

- Return to Start

テキスト入力欄に指示を入力し「Send Command to Robot」ボタンを押すと、後ろに置かれた小型ロボットが動き出し、指示に応じて巡回したり人を探したりします。

(執筆時にメインのロボットの近影を撮れてないことに気付き、意気消沈)

画面下部には ROS(Robot Operating System)のコード断片らしきテキストがリアルタイムで生成されており、Amazon Bedrock が「自然言語 → ROS コマンド」に変換している様子がわかります。

ユースケース セキュリティ監視ロボットを自然言語で操作

左側のスライドには『Interactive Security Surveillance Robot Use Case』と書かれており、想定ユースケースは「インタラクティブなセキュリティ監視ロボット」のようです。

- ロボットが施設内を巡回

- カメラで人や特定の行動を検知

- オペレーターは「自然言語で指示を出すだけ」

このシチューションで、

「右に曲がって、電話している人を探して」

「このエリアを四角形にパトロールして」

といった曖昧さを含んだ指示を LLM が解釈し、具体的な ROS コマンドとパラメータに落とし込んでくれるデモになっていました。

ロボット制御の専門知識がなくても『言葉でロボットを操れる』ことが、このデモの肝になっています。

Bedrock+サーバレス+IoT Core のシンプル構成

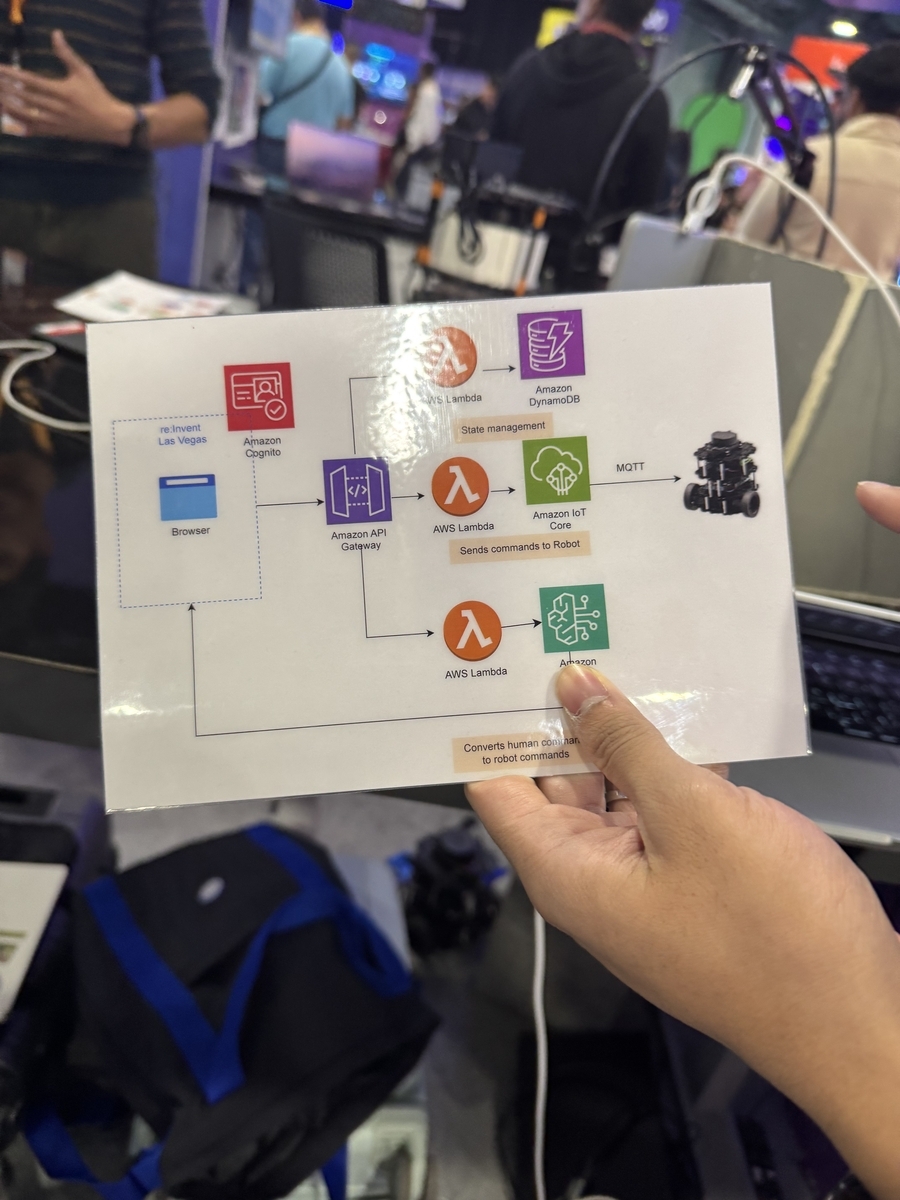

ブースではラミネートされたアーキテクチャ図も見せてくれました。

そこから読み取れた構成を整理すると、ざっくり次のような流れです。

- re:Invent 会場からブラウザで Web アプリにアクセス

- Amazon Cognito で認証

- Amazon API Gateway 経由で AWS Lambda を呼び出し

- Lambda が入力コマンドを Amazon Bedrock に渡して解釈させる 『人間の自然文 → ロボット用コマンド』への変換

- コマンドやロボットの状態は Amazon DynamoDB で管理(State management)

- 別の Lambda が Amazon IoT Core を通じてロボットへ MQTT で指示を送信

図の下部には『Converts human commands to robot commands』と説明があり、Bedrock が「自然言語コンパイラ」の役割を担っていることが強調されていました。

インフラ的はいかのようです。

- フロント:Browser + Amazon Cognito + Amazon API Gateway

- サーバレス:AWS Lambda(ビジネスロジック・Bedrock 呼び出し・ロボット制御)

- データ:Amazon DynamoDB(状態管理)

- デバイス連携:Amazon IoT Core(MQTT)

- 生成 AI:Amazon Bedrock

AWS らしいオーソドックスかつ拡張しやすい構成になっています。

でもお話し伺うと、AWS IoT Core のところはかなり作り込まれているとのことです。

興味を持ったポイント

デモを見ながら、個人的に面白いと思ったポイントを整理します。

『ROS の知識』と『現場の言葉』のギャップを埋めてくれる

ロボットを動かすには、本来は ROS や各種ミドルウェアの知識が必要です。

しかし現場でロボットを使いたい人(警備員・オペレーターなど)が、全員 ROS のトピック名や座標系を理解しているとは限りません。

このデモでは以下のステークホルダー と 役割 を考えました。

- 現場の人

- 「人が歩いているエリアを一周して確認して」と自然な言葉で指示

- システム側

- Bedrock がその意図を解釈し、「速度」「回転角」「停止条件」などを含んだ ROS コマンドに変換

生成 AI が「現場の言葉」と「ロボット制御の世界」を橋渡ししているのが印象的でした。

セーフティ機能も UI レベルで組み込まれている

画面には『EMERGENCY STOP』ボタンも用意されていました。

生成 AI による自律的な動作は便利な一方で、「万が一変なコマンドを出してしまったときに止められるか?」は現場ではとても重要です。

- AI がロボットを動かす

- でも、最終的な責任は人間が持つ

- そのための UI と制御フローを最初から設計に入れておく

この考え方は、エンタープライズ向けの導入にもそのまま応用できそうです。

エンタープライズへの応用アイデア

このデモはあくまで「監視ロボット」がテーマですが、構成そのものはかなり汎用的なので、いろいろな応用が想像できます。

- 工場・倉庫の自律走行ロボット

- 「この棚の前まで荷物を取りに行って」

- 「今日は 5 番ラインの周りだけ重点的に巡回して」など

- インフラ・設備点検ロボット

- 「3 階の電気室の温度を測って、前回より 5 度以上高ければ写真を撮って報告」

- 商業施設の案内ロボット

- 「エレベーター横までお客様を案内して、それから 1 階のフロアマップを表示」

共通しているとおもった箇所は以下です。

- 現場にいる人は「業務の言葉」で指示を出すだけ

- 生成 AI が、その裏側の複雑な制御や手順を肩代わりする

「人間が全部マニュアル操作するロボット」から、 「AI が翻訳して動かしてくれるロボット」へのシフトを、わかりやすく体感できるデモでした。

まとめ

『Command a Robot with Amazon Bedrock』ブースは、以下が印象的でした。

- 自然言語 → ROS コマンドの変換という分かりやすいテーマ

- Bedrock / Lambda / DynamoDB / IoT Core という実践的な構成

- かわいい見た目(ピンクの風船)とガチな中身のギャップ

AWS re:Invent では生成 AI の話題がどうしても「テキストやドキュメント」に偏りがちですが、 このブースは「物理世界のロボット」と組み合わせた事例として、 自分たちのお客様への応用をイメージしやすい内容だったと思います。

今後、社内検証や PoC のネタとしても面白そうなので、Bedrock+IoT の組み合わせはぜひ検討してみたいです。

現場からは以上です。